Qu'est-ce que la diffusion stable et comment maximiser sa puissance

Les progrès de l’intelligence artificielle prennent désormais le pas sur certains programmes qui permettront de générer des images. Vous pouvez voir l’outil Diffusion stable. Mais qu'est-ce que la diffusion stable? Il s'agit d'un outil de génération d'images. Son objectif principal est de générer des images à l'aide d'invites, et les gens trouvent attrayant et amusant de générer divers personnages et éléments ensemble. Apprenez-en davantage sur ce qu’est la diffusion stable et découvrez comment elle fonctionne.

Liste des guides

Partie 1 : Qu'est-ce que la diffusion stable Partie 2 : Qu'est-ce que la diffusion stable de la VAE Partie 3 : Qu'est-ce que Dreambooth en diffusion stable et comment l'installer Partie 4 : Qu'est-ce que l'échelle CFG en diffusion stable Partie 5 : Qu'est-ce que la diffusion stable de la force de débruitage Partie 6 : Qu'est-ce que la diffusion stable avec Clip Skip et comment l'utiliser Partie 7 : Qu'est-ce que la vitesse de génération de diffusion stable et comment l'accélérer Partie 8 : FAQ sur la diffusion stablePartie 1 : Qu'est-ce que la diffusion stable

Il s'agit d'un modèle d'apprentissage profond de texte en image, créant des images en saisissant des invites pour décrire le sujet principal. Par exemple, vous pouvez mettre « chat » et l'outil générera une image d'un chat. Cependant, il peut accentuer davantage ou ajouter plus de détails lorsque vous saisissez des invites complexes. Le réseau neuronal génératif devient plus qu'un outil d'IA, car il est également conditionné par d'autres tâches telles que l'outpainting, l'inpainting et la traduction d'image à image via des invites de texte.

Stable Diffusion a été développé et financé par Stability AI, mais le groupe CompVis de l'Université Ludwig Maximilian de Munich possède la licence technique pour le modèle de diffusion latente. En outre, le développement a été dirigé par les chercheurs Patrick Esser et Robin Rombach, qui ont obtenu davantage de données sur la formation auprès d'organisations à but non lucratif en Allemagne en tant que soutiens aux projets. Plus tard en octobre 2022, la société a levé 101 millions de dollars US après l'avoir initialement introduite en août 2022.

Partie 2. Qu'est-ce que la diffusion stable VAE

Vous avez peut-être rencontré ce problème lors de l'utilisation du générateur de photos AI, et VAE est utile pour l'outil. VAE signifie Variable Auto Encoder, utilisé pour affiner le décodeur afin de peindre de meilleurs détails. Il s'agit d'un ajout à l'outil d'IA, car il peut aider à obtenir des images plus nettes et des couleurs éclatantes et à améliorer la génération de mains et de visages.

Bien entendu, le VAE ne se limite pas à la diffusion stable, car tous les modèles sont dotés de VAE intégrés pour régler les détails. La comparaison sera le résultat entre chaque modèle et le résultat lorsque vous compresserez les images. De plus, il existe des fichiers VAE distincts que vous pouvez télécharger sur votre appareil. Pour essayer un décodeur, vous pouvez utiliser ce qui suit :

- Orangemix/anything VAE pour l'anime.

- Kl-f8-anime2 pour les dessins animés.

- Vae-ft-mse-840000-ema-pruned pour le réalisme ou les peintures.

Partie 3. Qu'est-ce que Dreambooth en diffusion stable et comment l'installer

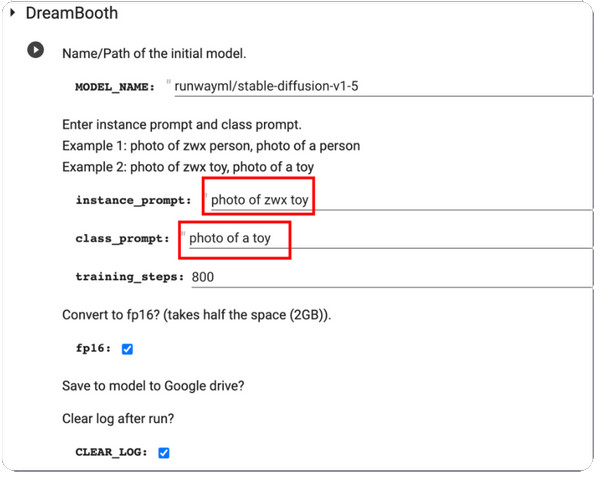

DreamBooth est un modèle de génération d'apprentissage profond qui affine les images générées, en particulier le sujet spécifique. Initialement, il est basé sur le modèle texte-image d'Imagen, mais malheureusement, Imagen ne dispose pas des poids pré-entraînés comme Stable Diffusion ou d'autres outils d'IA. DreamBooth a été développé par des chercheurs de Google et certains collègues de l'Université de Boston en 2022.

Le travail du modèle consiste à modifier et à affiner les photos générées, mais il est également capable de restituer des sujets familiers dans n'importe quel environnement et situation. Étant donné que la plupart des modèles de diffusion pré-entraînés doivent encore être améliorés dans cette catégorie, DreamBooth renforcera la formation des modèles de diffusion. Avec seulement cinq images, la modification d’images peut être effectuée avec des plateformes comme Stable Diffusion. Voici une brève instruction sur la façon d'utiliser DreamBooth sur Stable Diffusion :

Étape 1.Tout d’abord, vous devez disposer d’images de formation d’un sujet à utiliser sur DreamBooth. Assurez-vous que le sujet a des photos capturées. Procédez au redimensionnement des images à 512 x 512 pixels.

Étape 2.Ouvrez DreamBooth et entrez Invite d'instance et Invite de classe. Traitez les modifications en cliquant sur le Jouer bouton dans la partie gauche de l’interface.

Étape 3.Une fois terminé, testez-le et vous recevrez quelques échantillons générés par le modèle. Vous pouvez télécharger le fichier de point de contrôle du modèle depuis votre Google Drive et l'installer dans l'interface graphique.

Partie 4. Qu'est-ce que l'échelle CFG en diffusion stable

Vous pouvez trouver cette valeur définie dans le modèle du générateur de photos. Et comme c’est essentiel, vous devez apprendre ce qui vaut la peine d’optimiser les images. L'échelle de guidage gratuite du classificateur permet aux utilisateurs d'ajuster la proximité du résultat à partir de l'image d'entrée ou des invites utilisées. Par exemple, lorsque vous réglez l'échelle CFG sur une valeur plus excellente, la sortie sera plus similaire à l'image d'entrée mais devrait être déformée. D'un autre côté, une échelle CGF inférieure éloignera le résultat de l'invite principale tout en générant une meilleure qualité.

Mais quand faut-il utiliser l’échelle CFG en Diffusion Stable ? La réponse est simple : le générateur de photos IA ne peut pas créer quelque chose qui n'est pas à sa connaissance, donc l'échelle CFG vous aidera à joindre plusieurs sujets en augmentant sa valeur. Le seul inconvénient est le coût de la qualité de l'image, qui est proportionnel aux invites. Si cet outil vous intéresse, vous devez vous entraîner à calibrer la balance pour trouver le point idéal.

Partie 5. Qu'est-ce que la diffusion stable de la force de débruitage

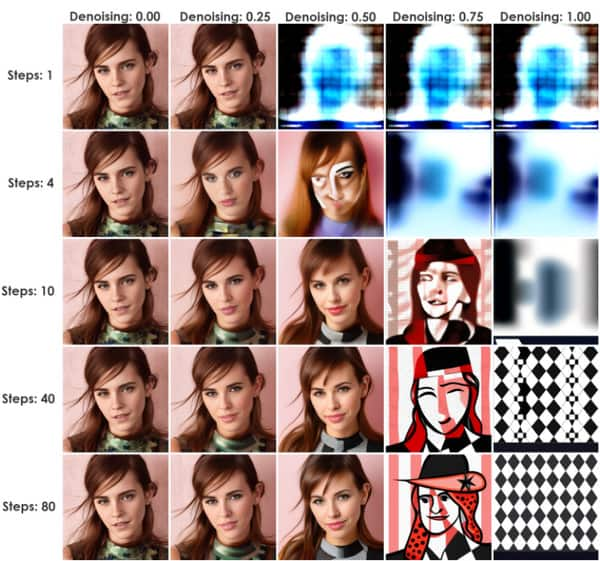

Cette méthode lance un processus qui ajoute du bruit aux images d'entrée. C'est juste un Upscaleur de diffusion stable. Il s'agit d'une excellente valeur pour la diffusion stable, car elle peut passer d'une image à l'autre (img2img) ou d'InPaint. La quantité de bruit est contrôlée par Denoise Strength, d'un minimum de 0 à un maximum de 1. Mettre la valeur à 0 réduira le bruit à zéro, créant une image similaire à l'image d'entrée. Sinon, la valeur 1 remplacera l'entrée par du bruit.

Vous pouvez utiliser la force du bruit comme méthode pratique pour déterminer la proximité de la sortie avec l'influence des images d'entrée. Un bon exemple est une force de débruitage plus faible qui rend les images générées plus proches de l'entrée, un paramètre idéal pour des modifications mineures. D'un autre côté, une force de débruitage plus élevée augmentera probablement la variation tout en réduisant la similarité des images d'entrée et de sortie. Par conséquent, des valeurs plus élevées sont utiles pour des modifications significatives.

Partie 6. Qu'est-ce que la diffusion stable avec Clip Skip et comment l'utiliser

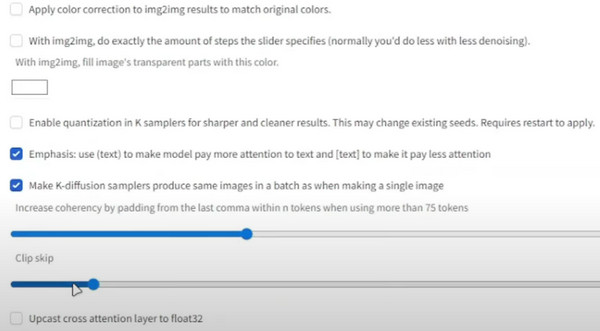

CLIP est une couche d'intégration utilisée pour l'analyse de textes. Sa structure est composée de couches, plus spécifiques pour chaque individu que la précédente. Par exemple, la couche 1 peut être « Personne », la couche 2 « Femme » ou « Homme ». La couche suivante sera « Parent, Père, Homme, Garçon, etc. ».

Son objectif est d'obtenir le modèle de texte précis, qui arrête la longue liste de couches, mélangeant finalement plus de données et vous donnant plus que ce dont vous avez besoin. Le meilleur exemple en est le modèle 1.5 avec 12 rangs de profondeur. Chaque calque intègre du texte et peut être mélangé avec d'autres détails, tels que la taille, la couleur, etc. CLIP ignore la dimension de l'espace de texte et obtient la sortie exacte. Voici comment l'utiliser :

Étape 1.Depuis le point de contrôle de diffusion stable, accédez aux paramètres et sélectionnez « Diffusion stable ».

Étape 2.Faites défiler vers le bas et sélectionnez « Ignorer le clip ». Réglez la valeur souhaitée, puis faites défiler vers le haut et cliquez sur le bouton « Appliquer les paramètres ».

Partie 7. Qu'est-ce que la vitesse de génération de diffusion stable et comment l'accélérer

Lorsque vous examinez la vitesse d’un générateur d’IA, vous vous attendez à ce qu’il faille un certain temps pour afficher les résultats. Cependant, Stable Diffusion a une vitesse de génération de 10 secondes. Ceci est uniquement destiné à l'utilisation générale de l'outil en ligne, mais le temps peut toujours être réduit jusqu'à quatre secondes lors de la souscription au forfait principal ou standard. C'est une façon d'accélérer la vitesse du modèle, mais la précision du résultat s'éloigne de l'entrée. Messages de diffusion stable. De plus, l’outil est gratuit avec seulement quelques limitations de fonctionnalités par rapport aux forfaits payants. Alors, comment accélérer la vitesse de production sans payer ?

La seule condition requise pour l'accélération est une carte Nvidia, qui peut appartenir aux séries 4000, 3000, 2000 et même 1000. Vous pouvez utiliser Lovelace, Ampere, Pascal Turing, etc. Pour une alternative, utilisez une précision inférieure comme float16 et exécutez moins d'étapes d'inférence.

Conseils bonus : modifier la taille des résultats de diffusion stable

Après avoir découvert le modèle d'IA, il y a encore une chose que vous devez savoir : la taille des fichiers est un facteur énorme pour les images, et elles peuvent consommer votre espace de stockage en raison de la taille des fichiers. Mais avec AnyRec Compresseur d'images gratuit en ligne, compresser les photos sera pratique. L'outil en ligne dispose de la dernière technologie d'IA pour aider à optimiser les téléchargements tout en réduisant la taille du fichier. Comme il génère des fichiers plus petits, l'utilisateur peut importer plus d'images à partir du dossier local et le compresseur les chargera instantanément.

- Compressez les images générées par diffusion stable avec qualité.

- Aucun filigrane n’est appliqué aux images compressées.

- Prend en charge les formats tels que JPEG, GIF, TIFF, BMP, PNG, etc.

- Corrigez automatiquement les nouveaux pixels déformés, flous et remplissez l'image.

Partie 8. FAQ sur la diffusion stable

-

1. Puis-je utiliser Stable Diffusion hors ligne ?

Oui. l'outil peut être utilisé sans connexion Internet. En effet, il peut stocker les données synthétiques localement, permettant ainsi aux modèles d’IA de s’habituer sans réseau Internet.

-

2. Quels sont les inconvénients du générateur de photos IA ?

Outre ses avantages, l'outil peut nécessiter beaucoup de calculs, alors qu'il prend du temps lorsqu'il s'agit de traiter des photos et des vidéos contenant des données plus volumineuses. Une autre raison est que la qualité dépend des données d’entrée et des paramètres réseau utilisés. Cela signifie que rien ne garantit que vous obtiendrez une image de haute qualité.

-

3. Ai-je besoin d’un équipement haut de gamme pour utiliser Stable Diffusion ?

Non. Le générateur de photos peut être utilisé sans la dernière version de l'ordinateur. Même si vous disposez de la version ultérieure, il suffira d’utiliser le générateur d’IA.

-

4. Où obtenir des invites textuelles ?

Stable Diffusion dispose d'un ingénieur d'invite de texte intégré qui vous aide à rechercher des invites. Entrez simplement un texte et cliquez sur le bouton Rechercher. Les résultats apparaîtront en quelques secondes avec des images comme échantillons.

-

5. De quel GPU ai-je besoin pour exécuter l'outil en ligne ?

Puisqu'il prend en charge la plupart des GPU, vous pouvez exécuter le générateur d'images AI avec Nvidia et AMD à 6 Go

Conclusion

Cet article explique qu'est-ce que la diffusion stable et comment cela fonctionne avec Clip Skip, VAE, DreamBooth, CFG Scale et Denoising Strength. D'un autre côté, vous pouvez utiliser AnyRec Free Image Compressor Online pour réduire la taille des fichiers des images générées. Son utilisation est entièrement gratuite et illimitée !