Cos'è la diffusione stabile e come massimizzarne la potenza

Il progresso dell’intelligenza artificiale sta ora prendendo il sopravvento su alcuni programmi che aiuteranno a generare immagini. Potresti vedere lo strumento Diffusione stabile. Ma cos'è la diffusione stabile? Questo è uno strumento per la generazione di immagini. Il suo scopo principale è generare immagini utilizzando suggerimenti e le persone trovano attraente e divertente generare insieme vari personaggi ed elementi. Scopri di più su cos'è la diffusione stabile e come funziona.

Lista guida

Parte 1: Cos'è la diffusione stabile Parte 2: Cos'è la diffusione stabile della VAE Parte 3: Cos'è Dreambooth su Stable Diffusion e come installarlo Parte 4: Cos'è la scala CFG nella diffusione stabile Parte 5: Cos'è la diffusione stabile della forza di denoising Parte 6: Che cos'è la diffusione stabile con salto clip e come utilizzarla Parte 7: Cos'è la velocità di generazione della diffusione stabile e come accelerare Parte 8: domande frequenti sulla diffusione stabileParte 1: Cos'è la diffusione stabile

Si tratta di un modello di deep learning, da testo a immagine, che crea immagini inserendo istruzioni per descrivere l'argomento principale. Ad esempio, puoi inserire "gatto" e lo strumento genererà l'immagine di un gatto. Tuttavia, può enfatizzare o aggiungere ulteriori dettagli quando si immettono istruzioni complesse. La rete neurale generativa diventa più di uno strumento di intelligenza artificiale, poiché è anche condizionata da altri compiti come l'outpainting, l'inpainting e la traduzione da immagine a immagine tramite istruzioni di testo.

Stable Diffusion è stato sviluppato e finanziato da Stability AI, ma il gruppo CompVis dell'Università Ludwig Maximilian di Monaco ha la licenza tecnica per il modello di diffusione latente. Inoltre, lo sviluppo è stato guidato dai ricercatori Patrick Esser e Robin Rombach, che hanno ottenuto ulteriori dati sulla formazione da organizzazioni no-profit in Germania come sostenitori dei progetti. Più tardi, nell'ottobre 2022, la società ha raccolto $101 milioni di dollari dopo averlo introdotto inizialmente nell'agosto 2022.

Parte 2. Cos'è la diffusione stabile della VAE

Potresti averlo riscontrato durante l'utilizzo del generatore di foto AI e VAE è utile per lo strumento. VAE sta per Variable Auto Encoder, utilizzato per mettere a punto il decoder per dipingere dettagli migliori. Si tratta di un'aggiunta allo strumento AI, poiché può aiutare a ottenere immagini più nitide e colori vivaci e a migliorare la generazione di mani e volti.

Naturalmente, VAE è qualcosa di più della semplice diffusione stabile perché tutti i modelli sono dotati di VAE integrati per elaborare i dettagli. Il confronto sarà il risultato tra ciascun modello e come risulterà quando comprimi le immagini. Inoltre, ci sono file VAE separati che puoi scaricare sul tuo dispositivo. Per provare un decoder, puoi utilizzare quanto segue:

- Orangemix/qualsiasi cosa VAE per gli anime.

- Kl-f8-anime2 per gli anime.

- Vae-ft-mse-840000-ema-potato per realismo o dipinti.

Parte 3. Cos'è Dreambooth su Stable Diffusion e come installarlo

DreamBooth è un modello di generazione di deep learning che perfeziona le immagini generate, in particolare l'argomento specifico. Inizialmente, si basa sul modello text-to-image di Imagen, ma sfortunatamente Imagen non ha i pesi pre-addestrati come Stable Diffusion o altri strumenti AI. DreamBooth è stato ulteriormente sviluppato dai ricercatori di Google e da alcuni colleghi dell'Università di Boston nel 2022.

Il lavoro del modello è quello di modificare e mettere a punto le foto generate, ma è anche in grado di riprodurre soggetti familiari in qualsiasi ambiente e situazione. Poiché la maggior parte dei modelli di diffusione pre-addestrati devono ancora essere migliorati in questa categoria, DreamBooth aumenterà la formazione per i modelli di diffusione. Con solo cinque immagini, la modifica delle immagini può essere eseguita con piattaforme come Stable Diffusion. Ecco una breve istruzione su come utilizzare DreamBooth su Stable Diffusion:

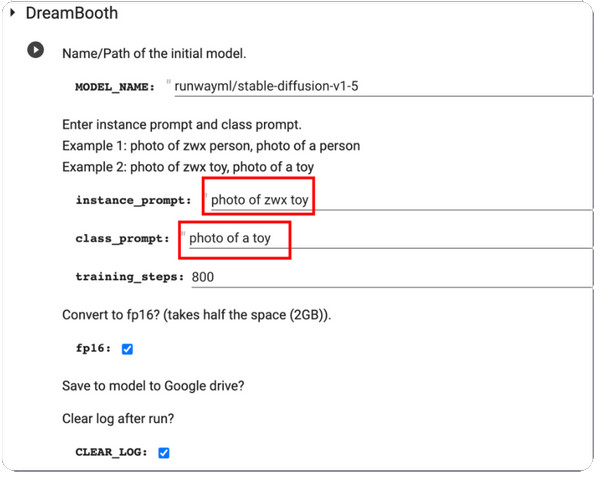

Passo 1.Innanzitutto, devi disporre di immagini di formazione di un soggetto da utilizzare su DreamBooth. Assicurarsi che al soggetto siano state scattate delle foto. Procedi con il ridimensionamento delle immagini a 512x512 pixel.

Passo 2.Apri DreamBooth ed entra Richiesta di istanza e Suggerimento di lezione. Elaborare le modifiche facendo clic su Giocare a pulsante dalla parte sinistra dell'interfaccia.

Passaggio 3.Al termine, testalo e riceverai alcuni campioni generati dal modello. Puoi scaricare il file del checkpoint del modello da Google Drive e installarlo nella GUI.

Parte 4. Cos'è la scala CFG nella diffusione stabile

Puoi trovare questo valore impostato nel modello del generatore di foto. E poiché è essenziale, devi imparare quanto vale la pena ottimizzare le immagini. La scala di guida gratuita del classificatore consente agli utenti di regolare la vicinanza del risultato dall'immagine di input o dai suggerimenti utilizzati. Ad esempio, quando si regola la scala CFG su un valore più eccellente, l'output sarà più simile all'immagine in input ma dovrebbe essere distorto. D'altra parte, una scala CGF inferiore porterà l'output lontano dal prompt principale generando al contempo una qualità migliore.

Ma quando è necessario utilizzare la scala CFG sulla diffusione stabile? La risposta è semplice: il generatore di foto AI non può creare qualcosa che non sia alla sua portata, quindi la scala CFG ti aiuterà a congiungere più soggetti aumentandone il valore. L'unico inconveniente è il costo della qualità dell'immagine, che è proporzionale alle istruzioni. Se sei interessato a questo strumento, devi esercitarti a calibrare la scala per trovare il punto giusto.

Parte 5. Cos'è la diffusione stabile della forza di denoising

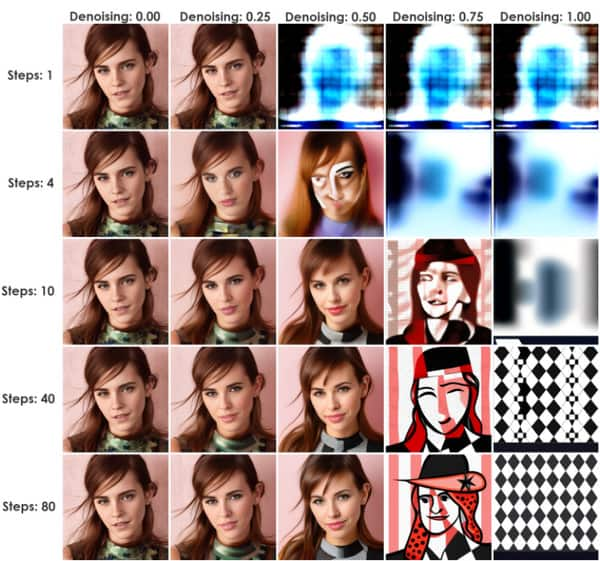

Questo metodo avvia un processo che aggiunge rumore alle immagini di input. È solo un Upscaler a diffusione stabile. È un valore eccellente per Stable Diffusion, poiché può passare da immagine a immagine (img2img) o InPaint. La quantità di rumore è controllata da Intensità rumore, da un minimo di 0 a un massimo di 1. Impostando il valore su 0 si ridurrà il rumore a zero, creando un'immagine simile all'immagine in ingresso. Altrimenti, il valore 1 sostituirà l'input con rumore.

È possibile utilizzare Intensità riduzione rumore come metodo pratico per determinare la vicinanza dell'output con l'influenza delle immagini in input. Un ottimo esempio è una forza di denoising inferiore che fa sì che le immagini generate sembrino più vicine all'input, un'impostazione ideale per modifiche minori. D'altra parte, una maggiore forza di denoising aumenterà probabilmente la variazione riducendo al tempo stesso la somiglianza delle immagini di input e di output. Pertanto, valori più alti sono utili per modifiche significative.

Parte 6. Che cos'è la diffusione stabile con salto clip e come utilizzarla

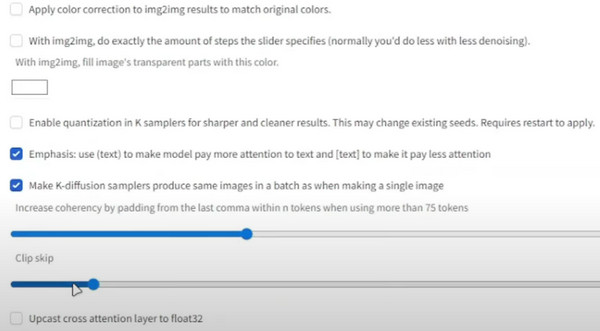

CLIP è noto come livello di incorporamento utilizzato per l'analisi dei testi. La sua struttura è composta da livelli, ognuno dei quali è più specifico del precedente. Ad esempio, il Livello 1 può essere "Persona" e il Livello 2 può essere "femmina" o "maschio". Il livello successivo sarà quindi "genitore, padre, uomo, ragazzo, ecc."

Il suo scopo è ottenere il modello di testo preciso, che interrompe il lungo elenco di livelli, mescolando eventualmente più dati e fornendoti più del necessario. Il miglior esempio di ciò è il modello 1.5 con 12 ranghi di profondità. Ogni livello ha l'incorporamento del testo e può essere combinato con altri dettagli, come dimensione, colore, ecc. CLIP salta la dimensione dello spazio del testo e arriva all'output esatto. Ecco come usarlo:

Passo 1.Dal checkpoint Diffusione stabile, vai alle impostazioni e seleziona "Diffusione stabile".

Passo 2.Scorri verso il basso e vai a "Clip Skip". Imposta il valore desiderato, quindi scorri verso l'alto e clicca sul pulsante "Applica impostazioni".

Parte 7. Cos'è la velocità di generazione della diffusione stabile e come accelerare

Quando osservi la velocità di un generatore di intelligenza artificiale, ti aspetteresti che ci vorrà del tempo per mostrare i risultati. Tuttavia, la diffusione stabile ha una velocità di generazione di 10 secondi. Questo è solo per l'utilizzo generale dello strumento online, ma il tempo può comunque ridursi fino a quattro secondi quando si abbona al piano principale o standard. Questo è un modo per accelerare la velocità del modello, ma la precisione del risultato si allontana dall'input Richieste di diffusione stabile. Inoltre, lo strumento è gratuito con solo alcune limitazioni di funzionalità rispetto ai piani a prezzo. Quindi, come si accelera la velocità di generazione senza pagare?

L'unico requisito per l'accelerazione è una scheda Nvidia, che può essere delle serie 4000, 3000, 2000 e persino 1000. Puoi utilizzare Lovelace, Ampere, Pascal Turing, ecc. In alternativa, utilizza una precisione inferiore come float16 ed esegui meno passaggi di inferenza.

Suggerimenti bonus: modifica la dimensione dei risultati di diffusione stabile

Dopo aver appreso del modello AI, c'è un'altra cosa che devi sapere: la dimensione del file è un fattore enorme per le immagini e possono consumare lo spazio di archiviazione a causa delle dimensioni dei file più grandi. Ma con AnyRec Compressore di immagini gratuito online, comprimere le foto sarà conveniente. Lo strumento online dispone della più recente tecnologia AI per aiutare a ottimizzare i caricamenti riducendo le dimensioni del file. Poiché genera file più piccoli, l'utente può importare più immagini dalla cartella locale e il compressore le caricherà immediatamente.

- Comprimi le immagini generate dalla diffusione stabile con qualità.

- Non è stata applicata alcuna filigrana alle immagini compresse.

- Supporta formati come JPEG, GIF, TIFF, BMP, PNG e altri.

- Correggi automaticamente i nuovi pixel distorti, sfocati e riempitivi dell'immagine.

Parte 8. Domande frequenti sulla diffusione stabile

-

1. Posso utilizzare Stable Diffusion offline?

SÌ. lo strumento può essere utilizzato senza una connessione Internet. Questo perché può archiviare i dati sintetici localmente, addestrando i modelli di intelligenza artificiale a essere utilizzati senza una rete Internet.

-

2. Quali sono gli svantaggi del generatore di foto AI?

Oltre ai suoi vantaggi, lo strumento può richiedere un utilizzo intensivo dei calcoli, mentre richiede tempo quando si tratta di foto e video con dati più estesi. Un altro è che la qualità dipende dai dati di input e dai parametri di rete utilizzati. Ciò significa che non vi è alcuna garanzia che otterrai un'immagine di alta qualità.

-

3. Ho bisogno di apparecchiature di fascia alta quando utilizzo Stable Diffusion?

No. Il generatore di foto può essere utilizzato senza l'ultima versione del computer. Anche se hai la versione successiva, sarà sufficiente utilizzare il generatore AI.

-

4. Dove trovare i messaggi di testo?

Stable Diffusion dispone di un ingegnere di prompt di testo integrato che ti aiuta a cercare i prompt. Basta inserire un testo e fare clic sul pulsante Cerca. I risultati appariranno in pochi secondi con immagini come campioni.

-

5. Di quale GPU ho bisogno per eseguire lo strumento online?

Poiché supporta la maggior parte delle GPU, puoi eseguire il generatore di immagini AI con Nvidia e AMD a 6 GB

Conclusione

Questo post spiega cos'è la diffusione stabile e come funziona con Clip Skip, VAE, DreamBooth, CFG Scale e Denoising Strength. D'altra parte, puoi utilizzare AnyRec Free Image Compressor Online per ridurre le dimensioni dei file delle immagini generate. È completamente gratuito e illimitato da usare!